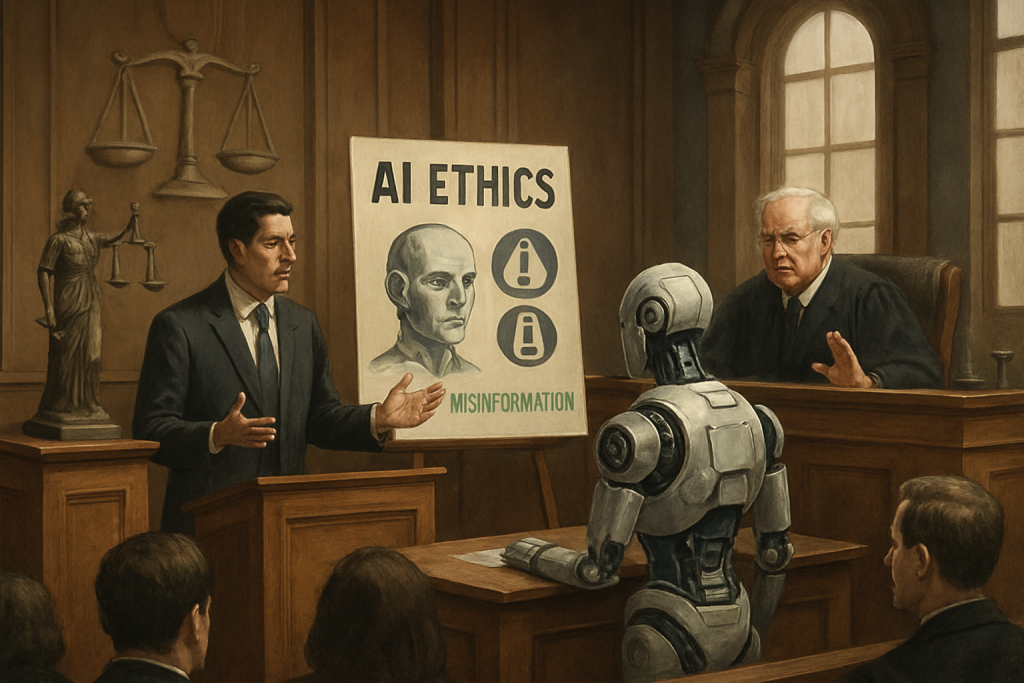

人工知能(AI)の進化は目覚ましいものがありますが、その利用にはまだ課題が残されています。特に、AIが生成する情報の正確性については、慎重な検証が必要です。最近、オーストラリアでAIが生成した誤った情報が法廷に提出され、大きな問題となりました。本記事では、この事例を通じて、AI利用における注意点と責任について考察します。

オーストラリアのベテラン弁護士が、殺人事件の法廷提出書類にAIが生成した偽の引用や存在しない判例を含めていたことが明らかになり、裁判官に謝罪しました。この問題は、ビクトリア州最高裁判所で発生し、AIが司法システムにもたらす混乱の一例として注目されています。弁護士は、AIが生成した情報が正確であると誤って判断し、独立した検証を怠ったことを認めました。このAIによる誤情報が原因で、事件の解決が24時間遅れる事態となりました。

この事例は、AIが事実に基づかない情報を生成する「幻覚(hallucination)」と呼ばれる現象の危険性を示しています。2023年には米国でも同様の事例があり、AIチャットボットが生成した架空の判例を提出した弁護士に罰金が科せられました。これらの事例は、AIツールを使用する際には、その出力内容を徹底的に検証する必要があることを浮き彫りにしています。裁判官は、AIの利用は、その生成物が独立して徹底的に検証されない限り許容されないと強調しています。

AIの導入が進む中で、弁護士やその他の専門家は、AIツールの能力と限界を理解し、その利用に責任を持つことが求められます。AIは強力なツールとなり得ますが、最終的な判断と検証は人間の専門家が行うべきです。今回の事例は、AIが提供する情報の便利さに安易に頼ることの危険性を示しており、AIと人間が協調して働く上での倫理的なガイドラインと厳格な検証プロセスの重要性を再認識させるものとなりました。

元記事: Australian lawyer apologizes for AI-generated errors in murder case